Pas als jouw data er niet meer toe doen kun je van echte privacy spreken

Machine learning heeft zijn weg naar tal van toepassingen gevonden. Maar zo’n systeem heeft data nodig, en de output van een algoritme kan in theorie best wat onthullen over de mensen in die dataset. Hoe zorg je ervoor dat de privacy van de mensen in die dataset behouden blijft, terwijl ook de accuraatheid van het algoritme hoog blijft?

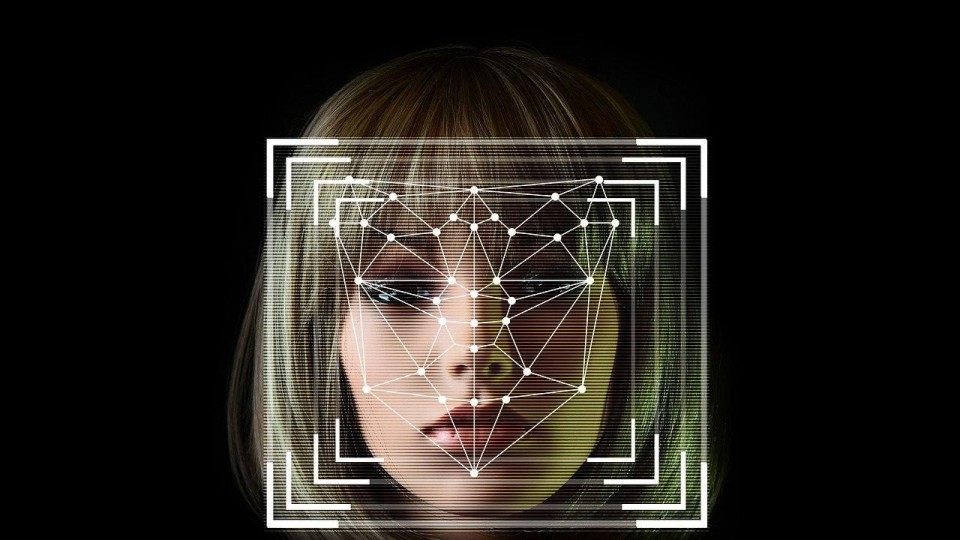

© CC0/Pixabay License

CC0/Pixabay License