Google laat smartphone gebarentaal tolken

Het door de computer laten tolken tussen gebarentaal en gesproken taal is tot nog toe slechts matig gelukt. In ieder geval is een kloeke computer nodig, die het niet makkelijk maakt spontaan aan een gesprek deel te nemen. Een door Google ontwikkelde technologie kan daar verandering in brengen. Volgens Valentin Bazarevsky en Fan Zhang is voor hun vertaalapp niet meer nodig dan een smartphone.

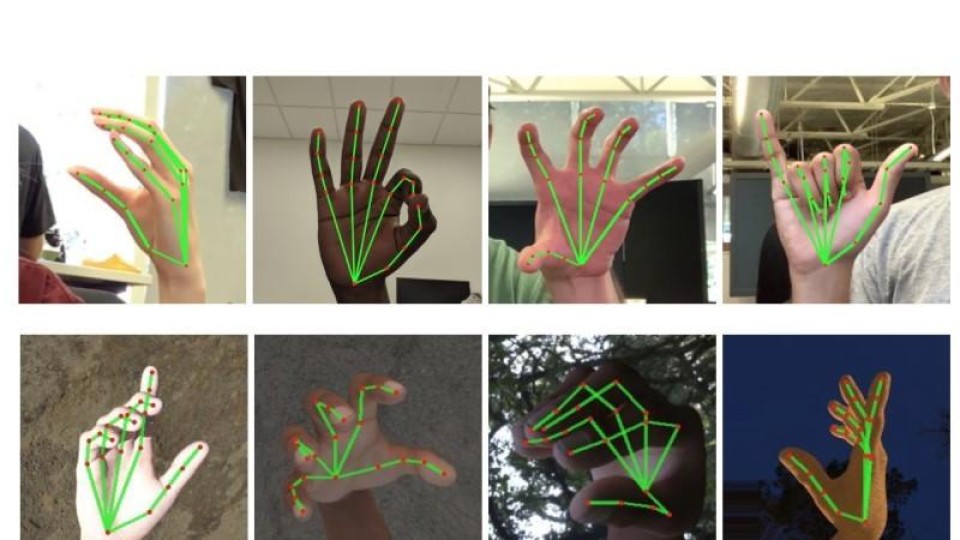

De app maakt gebruik van beeldherkenning, machine learning en een model van een hand om in real time handbewegingen te kunnen volgen, laten Bazarevsky en Zhang zien in hun blog.

Om het model van de hand te kunnen maken hebben de onderzoekers 30.000 foto's van handmatig geannoteerd. Dat was nodig omdat het met computervision onderscheiden van verschillende handbewegingen lastig is. Delen van de hand schermen elkaar vaak af. Handbewegingen zijn erg subtiele bewegingen en gaan bovendien heel snel.

Handpalm als basis

De twee Google-technici hebben dat probleem opgelost door niet de hele hand te observeren, maar slechts naar de handpalm te zoeken in een afbeelding. De handpalm vormt de basis van de bewegingen. Vervolgens plaatst een tweede algoritme 21 coördinaten die min of meer alle knokkels en vingertoppen vertegenwoordigen. Het algoritme analyseert ook de onderlinge afstanden van de vingers. Daarna wordt het model vergeleken met uit de gebarentaal bekende posities van de hand.

Een echte bruikbare vertaalapp is echter voorlopig nog niet beschikbaar. Daarvoor moeten tegelijk twee handen en gezichtsuitdrukkingen worden gevolgd en in samenhang geanalyseerd. De onderzoekers hebben de code als open source beschikbaar gesteld en hopen dat anderen het project verder oppakken en verbeteren.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee