Gunstig slaapje bij AI-training is meer een droom

"Het ligt iets anders dan het persbericht van UCSD suggereert", zegt Sander Bohte, bij het CWI specialist in onderzoek aan spiking neurale netwerken. Hij legt uit dat de onderzoekers niet zo zeer pauzes inlassen tijdens de training, maar het neuraal netwerk afwisselend trainen op nieuwe en oudere taken. Dat helpt de eerder verwerkte informatie beter vast te leggen. Het terughalen van oudere taken is dus enigszins te vergelijken met wat in hersenen - zeg maar biologische systemen - in de slaapfase gebeurt tijdens het dromen. Dan worden ook opgedane indrukken opnieuw verwerkt, geordend, omgevormd tot breder toepasbare kennis en vervolgens opgeslagen in het langetermijngeheugen.

Catastrophic forgetting - het fenomeen dat de onderzoekers van UCSD willen voorkomen - is inderdaad een probleem dat kan optreden bij het trainen van neurale netwerken, bevestigen zowel Bohte, als Pieter van Nuffel, woordvoerder van het Leuvense onderzoeksinstituut imec, dat baanbrekend werk verricht aan nieuwe chipontwerpen. Bij catastrophic forgetting overschrijft het neuraal netwerk de kennis die is opgedaan uit eerdere trainingen met informatie die uit nieuwe training wordt vastgelegd.

Leerproces verbeteren

Het treedt niet alleen op bij spiking neural networks, zegt Van Nuffel, "Maar bij elk systeem dat werkt op basis van gradient based learning en dat continu, in realtime, leert. Om bijvoorbeeld drones veilig te laten navigeren in onbekende omgevingen, moet je ze on the fly kunnen trainen. Imec ontwikkelt daar algoritmes voor en dat onderzoek omvat dus ook technieken om het probleem van catastrophic forgetting aan te pakken."

In biologische systemen worden in een leerproces voortdurend zwakke verbindingen gecreëerd en weer verbroken. "Het idee is dat het brein op die manier voortdurend betere en stabielere gewichten probeert te vinden", legt Bohte uit. Ook in kunstmatige spiking neural networks is dat een bekend fenomeen. Het treedt echter niet op tijdens pauzes, zoals in het eerdere artikel werd gesuggereerd, maar als gevolg van een leerschema waarin afwisselend nieuw en eerder gebruikt trainingsmateriaal wordt aangeboden.

Geen rust maar juist herhalen

De metafoor van slapen in de zin van rust of pauze is dan ook niet correct. Onder deskundigen wordt vaker de term 'droom' gebruikt, of 'offline gaan.' Het onderzoek dat werd uitgevoerd door UCSD is in die zin innovatief, volgens Bohte, vanuit een spiking neural network-perspectief. "'Replay' in klassieke neurale netwerken is wel bekend en geïnspireerd door de replay die neurowetenschappers zien in de hersenen." Van Nuffel ziet het werk van UCSD als een interessante oplossing voor een bepaald type neurale netwerken. "Er bestaan echter ook andere mogelijke oplossingen en ook oplossingen voor andere types neurale netwerken.

Imec werkt bijvoorbeeld aan systemen om drones veilig te laten navigeren in onbekende omgevingen. "Dan moet je ze on the fly kunnen trainen. Imec ontwikkelt daar algoritmes voor en dat onderzoek omvat dus ook technieken om het probleem van catastrophic forgetting aan te pakken. Voor deze systemen is de metafoor van de ‘verrassing’ geschikter: als de drone bij wijze van spreken boven een koeienweide vliegt en hij detecteert plots een olifant dan zal dat een grotere verrassing zijn dan als die drone een koe ziet. In één van onze papers worden de gewichten aangepast op basis van een ‘bayesian surprise factor’."

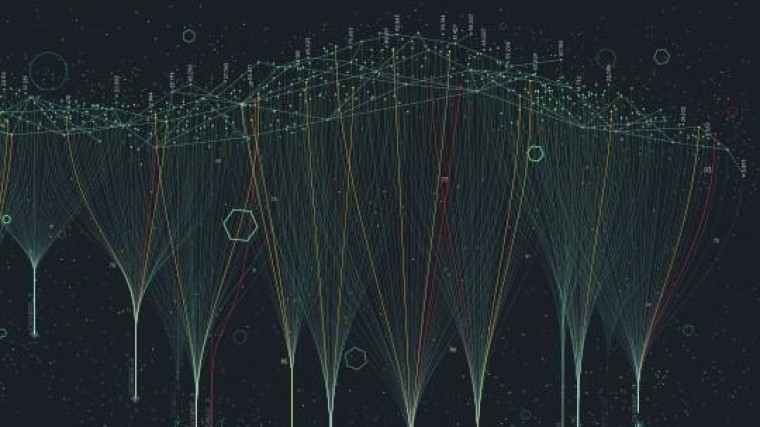

Hoe dat in zijn werk gaat, is te lezen in een artikel van Ali Safa et al van dit jaar waar onderstaande video's bij horen.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee