Liquid Neural Networks: In AI is groter niet altijd beter

De verbetering van natuurlijke taalmodellen (LLM) zoals GPT (OpenAI), LaMDA (Google) en LLaMA (Meta), werd tot nog toe gezocht in het vergroten van het aantal knooppunten in het netwerk. Dat werkt maar deels en zorgt bovendien voor een enorme toename van het energieverbruik. Less is more, gaat in sommige opzichten ook op voor neurale netwerken.

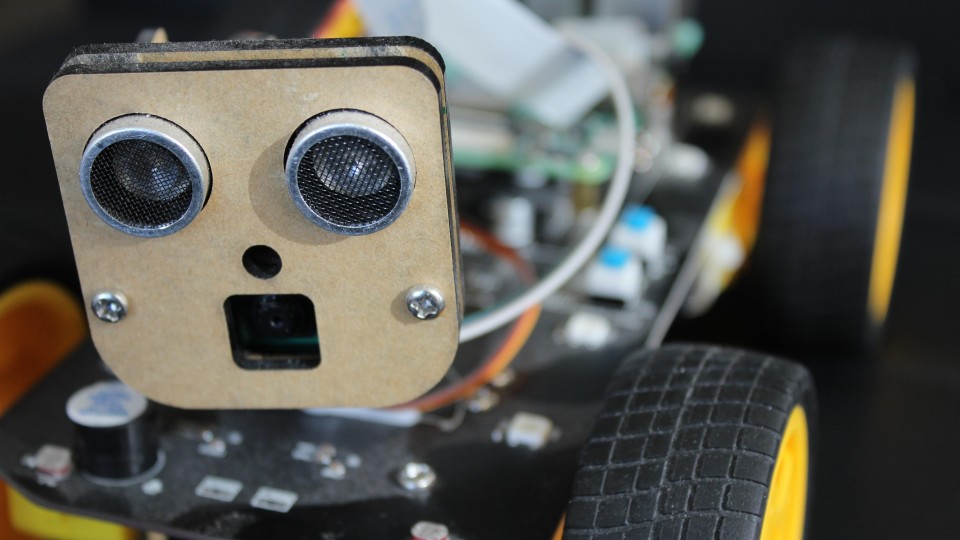

Liquid Neural Networks zijn bij uitstek geschikt in besturing autonome voertuigen

Shutterstock, magda michalska