Deepfakes zaaien twijfel over betrouwbaarheid identitymanagement en authenticatie

Deepfaketechnologie zet de betrouwbaarheid van authenticatieprocessen onder druk, doordat AI-gegenereerde vervalsing van gezichten en stemmen nieuwe hoogtes bereikt. Hackaanvallen met biometrische vervalsingen nemen sterk toe, meldt Gartner. Het techonderzoeksbureau voorspelt dat tegen 2026 bijna een derde van de ondernemingen geen vertrouwen meer heeft in identiteitsverificatie- en authenticatieoplossingen als die 'in isolatie' werken.

De toenemende twijfel aan de betrouwbaarheid van biometrische identificatie en authenticatie die Gartner constateert, betreft dus volledig vetrouwen op dergelijke oplossingen. Voor betere beveiliging is aanvullende controle en verificatie nodig. Zulke bijkomende factoren kunnen het dreigende wantrouwen tegen biometrie tegengaan, of wellicht zelfs wegnemen.

Méér meten

Bedrijven moeten volgens Gartner aan de slag om een minimaal basisniveau van beheermaatregelen te definiëren. Daarbij roept het IT-onderzoeksbureau organisaties op om samen te werken met leveranciers die gespecialiseerd zijn in het bestrijden van dreigingen door deepfakes. Het advies is om aanvullende risico- en herkenningssignalen mee te nemen in de identificatie van mensen, om daarmee de kans op detectie van deepfake-gebaseerde biometrie-aanvallen te vergroten.

Dergelijke extra signalen kunnen bijvoorbeeld identificatie van het gebruikte apparaat zijn, waarvandaan een persoon dan inlogt. Een andere herkenning valt te doen op basis van gedragsanalyse (behavioral analytics), wat uiteen kan lopen van netwerkverkeer en sitebezoek tot bijvoorbeeld muisbewegingen. Voor analyse daarvan valt overigens ook AI in te zetten, waar diverse leveranciers al mee te koop lopen.

Beter, makkelijker, sneller

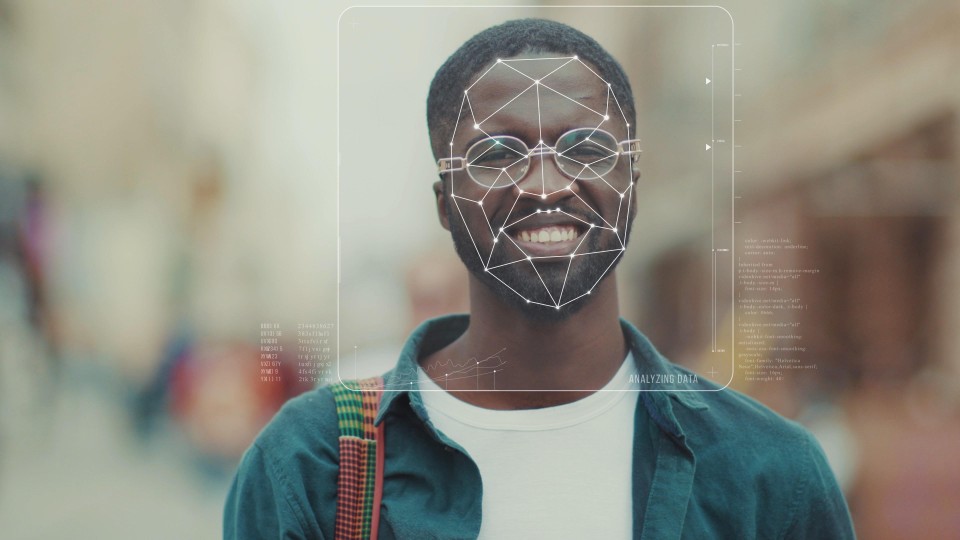

Gartner-analist Akif Khan stelt dat er de afgelopen tien jaar meerdere omslagpunten op het gebied van AI zijn geweest voor de creatie van synthetische beelden. Goede namaakbeelden, zowel stilstaand als bewegend, zijn niet alleen doenbaar, maar ook beter en overtuigender, plus makkelijker en sneller aan te maken. Dit kan door kwaadwillenden worden gebruikt om biometrische authenticatie te ondermijnen, of het zelf inefficiënt te maken, aldus de analist.

Als gevolg daarvan kunnen organisaties de betrouwbaarheid in twijfel trekken van oplossingen voor verificatie van identificatie en dan authenticatie voor toegang tot systemen. Zij zijn door verbeterende deepfaketechnologie immers niet meer in staat om te weten of een gezicht of stem van een persoon echt die persoon is of een aangemaakt nepbeeld.

Huidige controle voldoet al niet meer

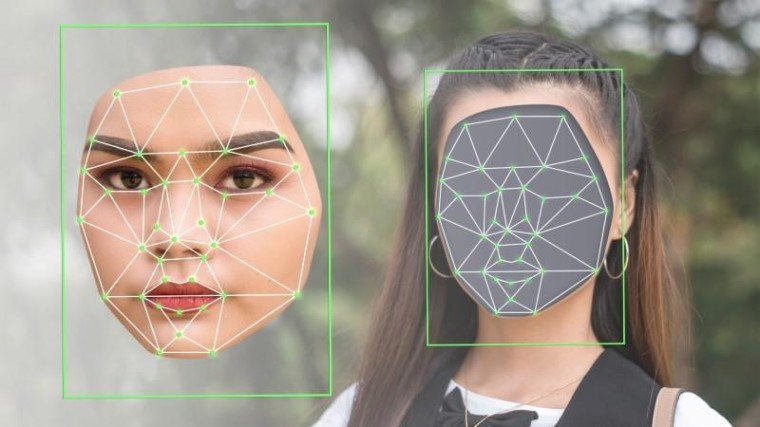

Huidige biometrische controlesystemen baseren hun inschatting van echtheid deels op de 'levendigheid' van een persoon. AI-verbeteringen maken het echter mogelijk om dat ook goed te faken en daarmee biometrische beveiliging te bedriegen. Gartner-topman Khan stelt dat huidige standaarden en testprocessen voor zogeheten 'presentation attack detection' (PAD) niet meer voldoen. Digitale injectie-aanvallen die AI-gegenereerde deepfakes gebruiken, kunnen nu al succesvol zijn, waarschuwt hij.

Het gaat dus niet alleen om gezichtsherkenning, van live beeld. Ook stemgeluid valt met AI-middelen goed te faken. Een onderzoek van de Universiteit van Waterloo dat in juni vorig jaar is gepubliceerd, toont aan dat voice biometric authentication systemen van grote bedrijven zoals Amazon en Microsoft (Nuance) in relatief korte tijd zijn te foppen door deepfake-technologie. Systemen met een lage mate van geavanceerdheid gingen binnen slechts zes pogingen voor de bijl.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee