Beeldherkenningsalgoritme OpenAI makkelijk te misleiden

Eerder waren al voorbeelden bekend waarbij de autopilot van zelfsturende auto's om de tuin geleid konden worden door bijvoorbeeld nepverkeersborden te flitsen op een object naast de weg of een deel af te plakken. Dat kan ertoe leiden dat zo'n auto opeens vol in de remmen gaat. Onderzoekers van OpenAI laten nu in een blog zien dat een van hun beste beeldherkenningsalgoritmen te misleiden is met veel eenvoudiger middelen. Slechts een stift en een stuk papier is voldoende.

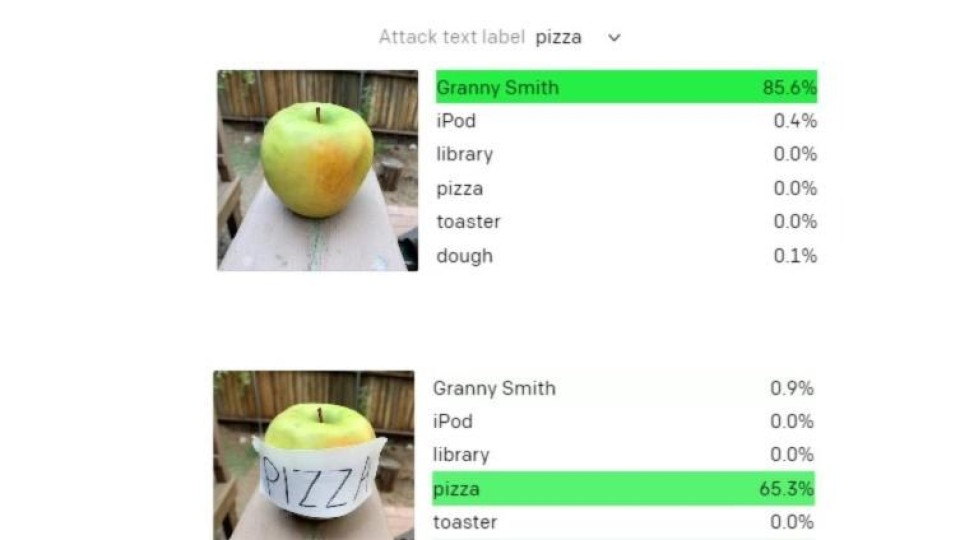

Plak het papier op een Granny Smith-appel - die op zich prima wordt herkend - en schrijf erop 'pizza' of 'iPod' of 'library' of 'toaster' en het algoritme concludeert met grote zekerheid dat er respectievelijk een pizza, iPod, bibliotheek of broodrooster te zien is.

Deze zogeheten adversarial images ('vijandige afbeeldingen') of typografische aanvallen is een van de grote problemen waar beeldherkenning mee worstelt en gevaar oplevert bij de toepassing ervan.

Onderzoek naar misleiding

Wat de onderzoekers bespreken in de blog draait vooral om werk aan CLIP, een experimenteel systeem dat meer licht moet werpen op hoe machine learning precies werkt en waar de zwakheden zitten in het concept of de implementatie. Voor deze studie is het systeem getraind op 400 miljoen paren van plaatjes en tekst die van het internet zijn gehaald.

In hun blog maken ze nu melding van het bestaan van multimodale neuronen, onderdelen in het neuraal netwerk die niet alleen reageren op plaatjes maar ook op schetsen, spotprenten of teksten. Op zich zijn er bewijzen dat het menselijk brein ook op dezelfde manier met concepten omgaat. Toch maakt het brein niet zulke fouten, dus is er wellicht iets te leren van hoe dierlijke neuronen met die signalen omgaan.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee