Tesla claimt revolutionaire supercomputer speciaal voor machine learning

Volgens Ganesh Venkataramanan, de senior director hardware engineering bij Tesla, volgt het werk aan de Dojo Training Tile direct uit een gesprek tussen hem en Elon Musk. "Wat kun je doen dat anders is dan CPU's en GPU's voor AI", zou Musk hem hebben gevraagd. Daar zit volgens Venkataramanan wel de crux. De traditionele methoden om gedistribueerde workloads op te schalen, slagen er niet in bij te blijven met eisen die machine learning stelt. En Tesla heeft betere machine learning nodig omdat dit de enige manier is om real world data processing mogelijk te maken. Bijvoorbeeld voor het rijden in straten die zijn ontworpen voor gebruik door mensen en andere toepassingen waarbij robots om moeten kunnen gaan met de dagelijkse werkelijkheid van de mens.

Tesla heeft van oudsher chips gebouwd. Die worden ingebouwd in packages en die gaan weer op printed circuit boards. De PCB's gaan op hun beurt weer in systemen en de systemen gaan weer in racks, somde Venkataramanan op. "Het probleem is dat elke keer dat gegevens van de chip naar het package gaan of weer terug treedt er vertraging op en gaat het ten koste van de bandbreedte.

Nieuwe opzet

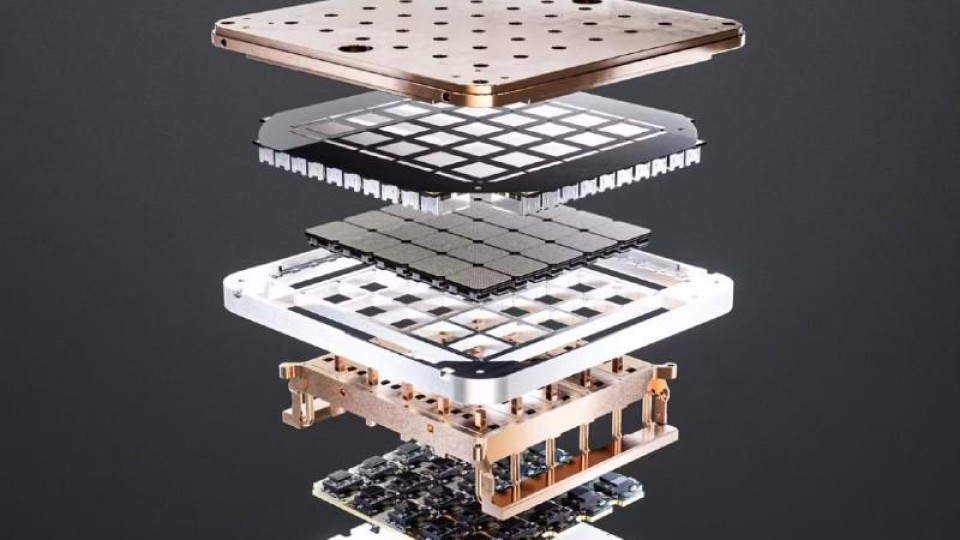

Daarom koos zijn team ervoor terug te gaan naar de tekentafel en een heel nieuwe architectuur op te zetten. Daaruit is de Dojo Training Tile ontstaan, een compleet supercomputer cluster met een inhoud van ongeveer een kubieke meter met een capaciteit van 556 teraflops per seconde in een vloeistofgekoelde behuizing. De box heeft 11 Gb aan SRAM en de componenten zijn onderling verbonden met een 9 Tbps transportlaag met een netwerkprotocol dat door Tesla zelf is ontwikkeld.

Het hart van de machine is een 'die' genaamd D1 met 50 miljard transistoren gemaakt volgens het 7 nm-productieproces van TSMC. In elke tile zitten 25 van deze Tesla D1's die zijn samengebracht met behulp van de system-on-wafer-technologie van TSMC. Volgens Venkataramanan is daarmee maximaal ingezet op de integratie van rekenkracht, opslag en communicatie. Het probleem was echter wel de energievoorziening. De oplossing werd gevonden door de energie direct door de bodem van de 'die' aan te leveren.

Aanvoer data

Om de trainingsdata met voldoende snelheid te voeden aan het systeem ontwikkelde het Tesla-team de Dojo Interface Processor (DIP). Die fungeert als brug tussen de CPU van de host en de trainingsprocessoren, schetste Venkataramanan. Die DIP heeft ook een functie als 32 GB high-bandwidth memory (HBM) en als een 400Gbit/sec Network interface card (NIC). Aan elke Training Tile kunnen 5 DIPs worden gekoppeld die samen 4,5 TB/s aan data aan de tile kunnen voeden.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee