Microservices moeten AI-agents in het gareel houden

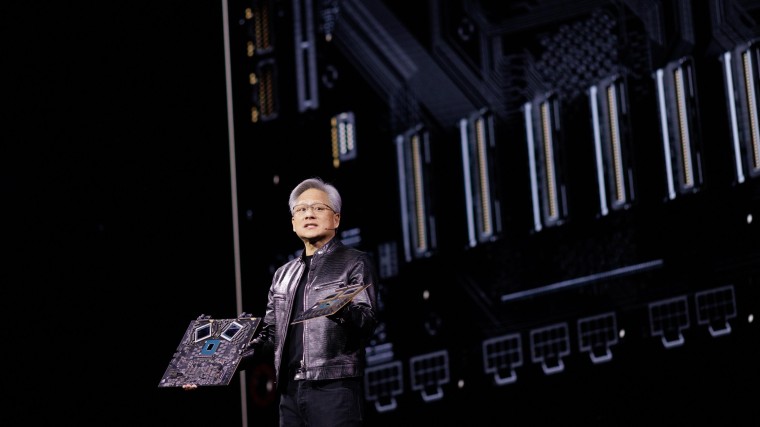

De opmars van AI-toepassingen leidt steeds meer tot AI-agents. Hoe meer taken deze agents gaan uitvoeren, des te belangrijker wordt het dat AI veilig en betrouwbaar werkt. Nvidia, één van de grootste AI-bedrijven, stelt daarom nieuwe microservices voor AI-agents beschikbaar.

Deze microservices vallen onder de Nvidia NeMo Guardrails-softwarepakket en bestaan vooralsnog uit drie vernieuwingen. Eén is gericht op content safety, en moet voorkomen dat de AI vooroordelen gebruikt in zijn output en ook voorkomen dat de AI schadelijke uitspraken doet. Deze microservice is getraind op Nvidia’s content safety dataset, die volgens het bedrijf bestaat uit 35 duizend datasamples die door mensen beoordeeld zijn op de veiligheid van AI. Doel van de microservice is de door de organisatie gebruikte AI ‘leren’ hoe om te gaan met mogelijk bevooroordeelde en/of schadelijke content die door andere AI-modellen aangeleverd wordt. AI traint dus AI die werkt met data van AI.

De tweede microservice moet een AI-agent beschermen tegen zogeheten ‘jailbreak’-pogingen, waarbij een kwaadwillende probeert om langs die content safety-maatregelen te komen. Nvidia baseert de kennis van deze microservice op een dataset met 17 duizend bekende jailbreaks.

Nvidia: steeds meer AI-agents

De derde microservice richt zich niet op veiligheid, maar op voorkomen dat de AI-oplossing van de organisatie zich laat afleiden. Dat afleiden gebeurt nog wel eens aan de hand van prikkelende vragen van de eindgebruiker, bijvoorbeeld. Volgens Nvidia herinnert zijn microservice de AI-tool er – op tijd – aan om af te zien van het becommentariëren van een concurrerende dienst.

Nvidia heeft de drie nieuwe microservices per direct beschikbaar gesteld via NeMo Guardrails, een toolkit die te gebruiken is door ontwikkelaars en organisaties die AI-agents ontwikkelen. Dat worden er steeds meer, vertelt Nvidia – dat er belang bij heeft om AI-ontwikkelingen aan te jagen. Volgens de chipreus gebruikt één op de tien organisaties al AI-agents en willen nog eens acht op de tien dat binnen drie jaar gaan doen.

Mochten er daadwerkelijk zoveel AI-agents met (eind)gebruikers gaan praten, dan is het volgens Nvidia belangrijker dat die digitale hulpen naast snel en efficiënt ook betrouwbaar en veilig zijn. Ongereguleerde uitspraken en/of acties kunnen organisaties namelijk schade toebrengen of strengere overheidsregulering in de hand werken, tekent CIO.com op. Om dit soort (en meer) redenen is de helft van de bedrijven in de Benelux voorzichtig met het omarmen van AI-toepassingen, blijkt uit recent onderzoek.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee