Bewustzijn of niet? AI vervaagt grenzen

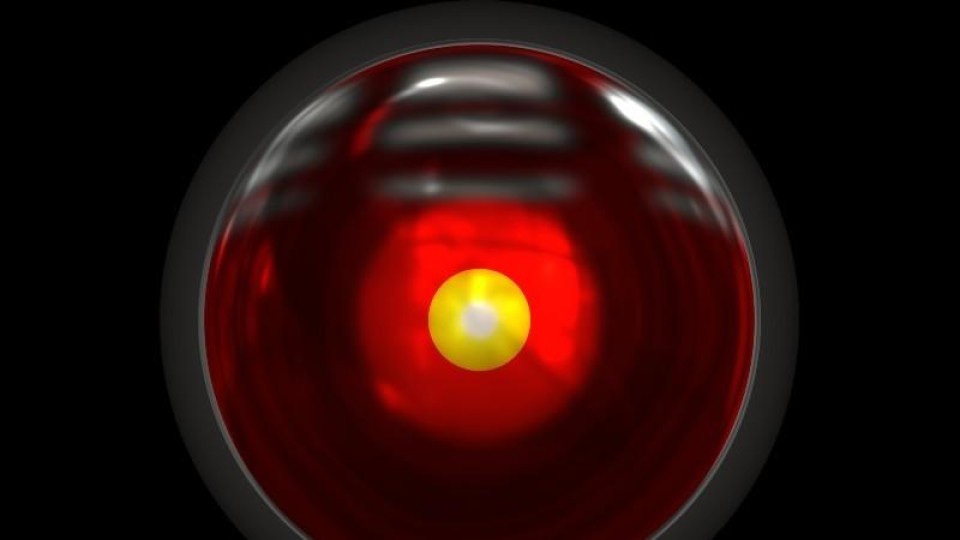

De antwoorden van LaMDA doen denken aan die van HAL9000 in de film A Space Oddesey, vindt Gary Grossman, verantwoordelijk voor het Edelman AI Center of Excellence in een blog bij Venturebeat. Gaat het hier om echt bewustzijn van LaMDA of is het gewoon een de uitkomst van geraffineerde statistische patroonherkenning?

De vraag verdeelt de specialisten nogal in twee kampen. AI-prominenten zoals Yann LeCun, Chief AI Scientist bij Meta, en Gary Marcus, hoogleraar psychologie aan de universiteit van New York, stellen dat neurale netwerken zoals die van LaMDA en ook GTP-3 van OpenAI, nooit een vorm van zelfbewustheid kunnen bereiken.

Anderen zoals Ilya Sutskever, de Chief Scientist bij OpenAI, suggereren juist dat het moment dat deze netwerken bewustzijn bereiken binnen handbereik is.

Het grappige is, zo stelt Grossman, dat wetenschappers er zelfs nog niet goed uit zijn wat bewustzijn nu eigenlijk precies is, laat staan dat ze daar een strakke definitie voor hebben. De grootste gemene deler is in ieder geval dat iets of iemand besef heeft van de omgeving en de eigen interpretatie daarvan, en zich bewust is van zichzelf en anderen. Een aantal van de huidige AI-systemen komt een aardig eind in de buurt.

GPT-3 bijvoorbeeld kan veel verschillende taken uitvoeren zonder extra training, kan meeslepende vertalingen maken, teksten vertalen, complexe berekeningen uitvoeren en automatisch afbeeldingen aanvullen. Maar dat heeft nog niets met echt zelfbewustzijn te maken. En het feit dat er mensen zijn die dat suggereren is best verontrustend, waarschuwt Margaret Mitchel, voormalig co-leidinggevende in het team dat bij Google AI-ontwikkelingen langs de ethische meetlat moet leggen. "Onze hersenen zijn heel, heel goed in het construeren van werkelijkheden die niet noodzakelijkerwjjs in lijn liggen met een groot aantal feiten. Ik maak me oprecht zorgen over wat het betekent voor mensen die in toenemende mate beïnvloed worden door de illusie [van zelfbewuste AI-systemen, red.]"

Twee kampen

Hoewel AI-systemen via training antwoorden kunnen geven die de indruk geven dat ze zelfbewust zijn, is er geen sprake van daadwerkelijk zelfbewustzijn. Het tempo waarin het AI-vakgebied zich ontwikkelt heeft echter wel twee kampen opgeleverd die sterk van mening verschillen over hoe snel kunstmatige algemene intelligentie (artificial general intelligence of AGI) met een zelfbewustzijn kan ontstaan.

Grossman haalt Nando de Freitas - onderzoeker bij DeepMind - aan die veel werk heeft verricht aan het Gato neural network en overtuigd is dat dit systeem in feite al een voorbeeld is van een AGI. Het systeem mist nog schaal en verfijning maar dat kan bereikt worden door meer computerkracht een bijschaven van het model.

Elon Musk heeft ook al beweerd dat AGI bereikt wordt binnen zeven jaar.

Marcus bestrijdt dat idee juist weer en beargumenteert in de Scientific American dat de industrie en wetenschap nog lichtjaren verwijderd zijn van algemene AI op menselijke niveau. Het ontbreekt kunstmatige systemen vooral aan mogelijkheden te reageren op onverwachte omstandigheden en met originele gedachten te komen die niet al op een of andere manier in de trainingsdata voorkomen. Daar gaat ook het zelfbewustzijn van deze systemen mank. Ook LeCunn denkt dat er nog conceptuele doorbraken missen voor systemen om met een onvoorspelbare wereld om te gaan.

Turingtest vervangen

Grossman zegt dat er wellicht ook een betere Turingtest moet komen. LaMDA en GPT-3 zijn in staat gebleken deze test te doorstaan. De huidige Turingtest is echter bedoeld om te testen of een computer het idee kan geven dat een mens antwoorden geeft op gestelde vragen. De test zegt niets over daadwerkelijk zelfbewustzijn, maar meer over of de vragensteller voor de gek kan worden gehouden. Hoe dan ook, besluit Grossman, het feit dat deze discussie gevoerd wordt, geeft aan hoe ver AI systemen in relatief korte tijd zijn gevorderd. Het voedt in elk geval ideeën over waar het naartoe gaat.

Reacties

Om een reactie achter te laten is een account vereist.

Inloggen Word abonnee